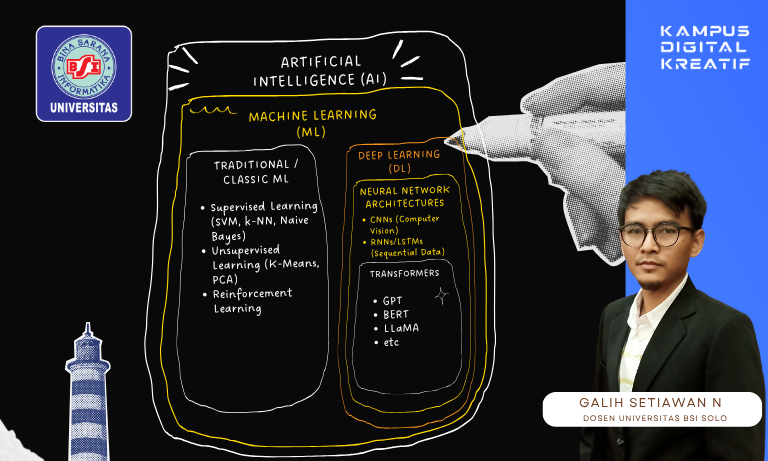

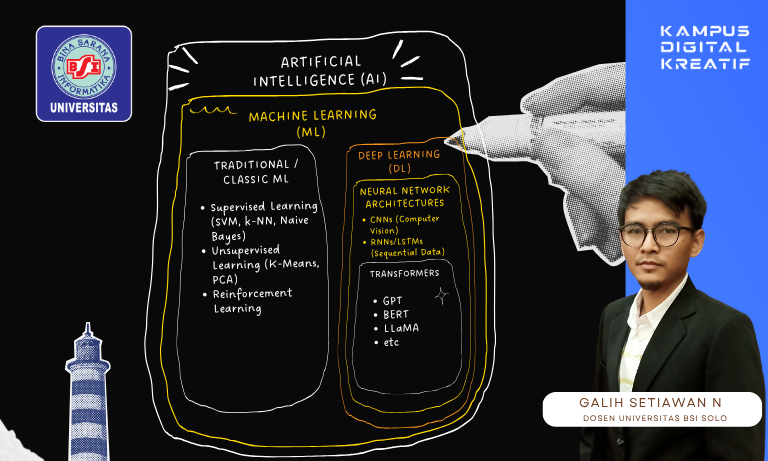

Dalam gelombang teknologi kecerdasan buatan (AI) yang berkembang pesat, arsitektur Transformer menjadi fondasi utama dari model-model bahasa besar (Large Language Models/LLM) seperti GPT, BERT, hingga LLaMA. Model ini tak hanya memahami bahasa manusia, tapi juga mampu menghasilkan teks yang sangat alami, menjadikannya pusat dari kemajuan terbaru dalam pemrosesan bahasa alami (NLP).

“Model seperti GPT dan BERT adalah puncak evolusi pembelajaran mesin. Mereka tak sekadar mengenali bahasa, tapi bisa berinteraksi dan merespons dengan konteks,” kata Galih Setiawan Nurohim, M.Kom, dosen Sistem Informasi Universitas Bina Sarana Informatika (UBSI) Kampus Solo, saat ditemui di sela seminar teknologi cerdas di Surakarta.

Transformer: Kerangka Otak Mesin Modern

Diperkenalkan oleh Google pada tahun 2017, Transformer menggunakan mekanisme self-attention untuk memahami hubungan antar kata dalam kalimat, jauh lebih efisien dibanding model RNN atau LSTM yang mendahuluinya. Dari fondasi ini, muncul generasi LLM yang kini mengubah cara kita berkomunikasi dengan mesin.

Model-model yang berbasis Transformer:

- BERT (Bidirectional Encoder Representations from Transformers): Unggul dalam memahami konteks teks dua arah. Cocok untuk klasifikasi, ekstraksi entitas, dan analisis sentimen.

- GPT (Generative Pre-trained Transformer): Fokus pada text generation, digunakan dalam chatbot, penulisan otomatis, hingga kode pemrograman.

- LLaMA (Large Language Model Meta AI): Model efisien buatan Meta yang dapat dilatih dengan sumber daya lebih kecil namun tetap berperforma tinggi.

“Transformer adalah transisi penting dari pemrosesan sekuensial menjadi paralel. Ini memungkinkan pelatihan model skala raksasa seperti GPT-4 dan LLaMA 3,” jelas Galih.

Dari AI ke Deep Learning: Menelusuri Akar Kecerdasannya

Meski transformer menjadi sorotan hari ini, keberadaan mereka tidak lepas dari evolusi panjang di bawah payung besar Artificial Intelligence (AI).

Artificial Intelligence: Payung Kecerdasan Mesin

AI adalah disiplin ilmu yang berusaha meniru kecerdasan manusia ke dalam mesin. Ini termasuk kemampuan logika, pengambilan keputusan, hingga pembelajaran. Sejak Konferensi Dartmouth tahun 1956, AI telah berevolusi dari sistem berbasis aturan menuju pembelajaran adaptif yang lebih fleksibel.

Machine Learning: Ketika Mesin Belajar Sendiri

Machine Learning (ML) merupakan metode dalam AI di mana mesin belajar dari data. Alih-alih diprogram secara eksplisit, sistem ML mengidentifikasi pola dan menyesuaikan perilakunya berdasarkan data yang diterima.

Jenis utama ML meliputi:

- Supervised learning – belajar dari data berlabel

- Unsupervised learning – mencari struktur tersembunyi tanpa label

- Reinforcement learning – belajar dari feedback reward/penalty

Deep Learning: Otomatisasi Kognitif Skala Besar

Deep Learning (DL) adalah subbidang ML yang menggunakan jaringan saraf dalam (deep neural networks). Di sinilah model seperti GPT dan BERT dikembangkan, karena DL mampu memproses data mentah secara end-to-end tanpa fitur buatan manusia.

“Kalau machine learning masih sering mengandalkan fitur buatan, deep learning memungkinkan mesin mengekstrak sendiri dari data mentah, seperti suara, teks, atau gambar,” terang Galih.

Tantangan dan Etika AI Generatif

Penggunaan luas model transformer membawa tantangan baru: bias dalam data pelatihan, hasil model yang sulit dijelaskan (black box), serta isu privasi pengguna. Inilah yang mendorong lahirnya tren Explainable AI (XAI) dan regulasi etika teknologi.

Kesimpulan

AI tidak lagi sekadar konsep futuristik. Dari Transformer lahir GPT, BERT, dan LLaMA, mesin yang tidak hanya paham bahasa manusia, tapi bisa menggunakannya secara alami. Memahami hirarki dari AI ke ML, DL, dan akhirnya ke model generatif seperti GPT, adalah kunci untuk memanfaatkan teknologi ini secara bijak dan strategis di masa depan.